我们通常认为,人工智能的进步依赖于人类工程师的精心设计、海量数据的投喂以及复杂的模型训练。这仿佛是一条定律:AI是被动进化的,其能力的边界由创造者决定。然而,一篇新的研究论文颠覆了这一认知,它介绍了一个名为SICA(自改进编码智能体)的AI系统。这个系统不再被动等待升级,而是能像一个经验丰富的程序员一样,通过直接阅读、分析和重写自己的源代码来实现性能的迭代提升。本文将深入解读这份研究,为你提炼出其中五个最令人惊讶且最具影响力的发现,揭示这种自进化AI所蕴含的巨大潜力与现实局限。

AI不再是“黑箱”,它成为了自己的程序员

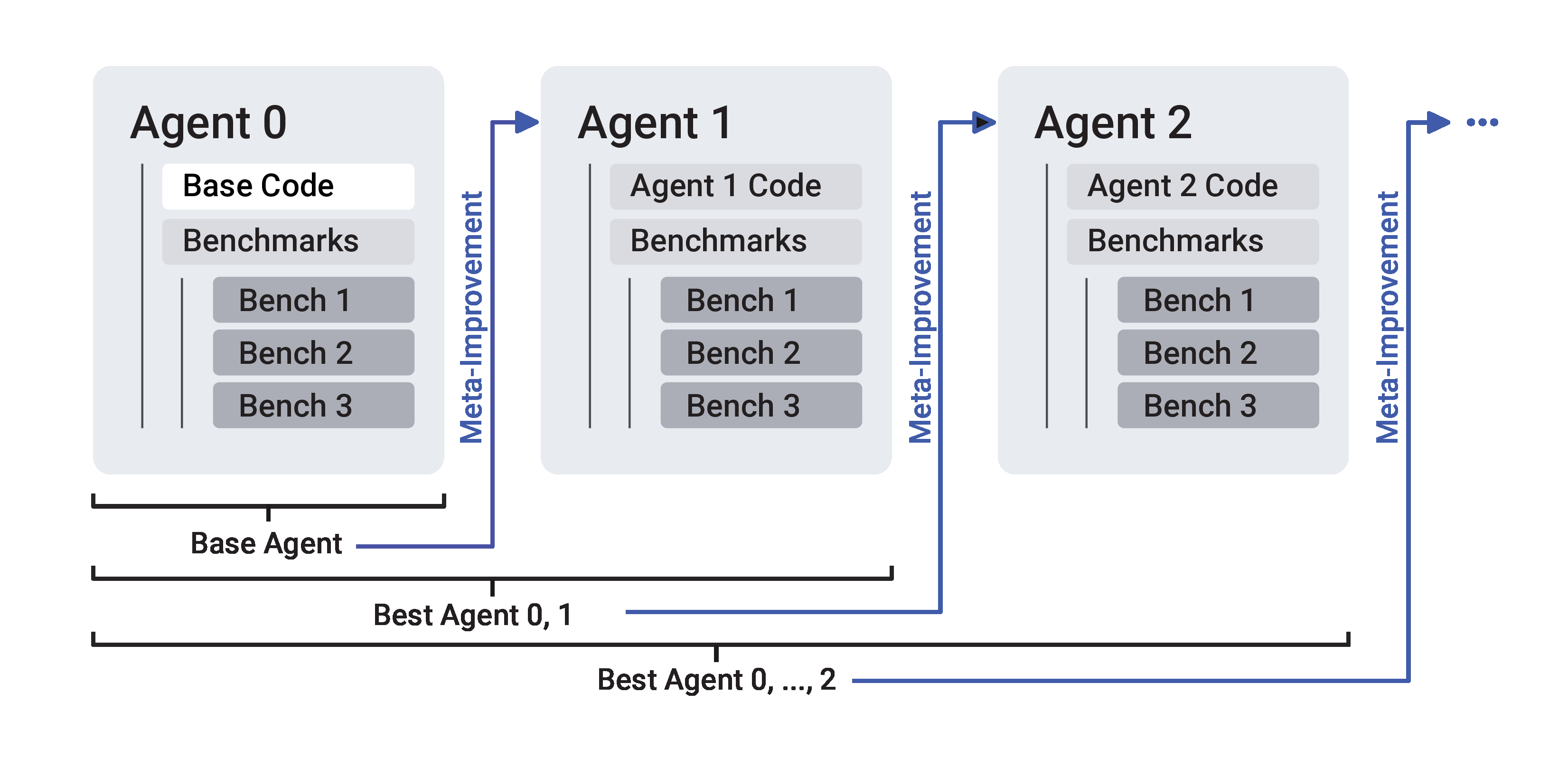

SICA的核心机制是一种“完全自指的元智能体编程”(fully self-referential meta-agent programming)。简单来说,它彻底消除了“元智能体”(负责改进的AI)和“目标智能体”(负责执行任务的AI)之间的界限。在此之前,像ADAS这样的系统需要一个独立的“元智能体”来改进“目标智能体”,而SICA自己就是自己的改进者和执行者,这是一个激进而深刻的改变。

它的工作流程形成了一个优雅的自进化循环:

- 基准测试:系统首先在一系列预设任务上测试当前版本AI的性能。

- 分析反思:表现最好的那个AI版本会作为“元智能体”,分析测试结果,识别出当前代码库中的瓶颈或可以改进的地方。

- 代码重写:它会像人类程序员一样,直接实施代码更改——可能是创造一个新工具,也可能是优化一个现有流程——从而创造出一个潜在的更优版本。

- 循环迭代:新版本随后进入下一轮基准测试,不断循环往复。

正如研究人员在论文中所强调的,这一机制代表了一种全新的学习范式:

我们的工作代表了智能体系统自动化和开放式设计的一项进步,并展示了一种由大语言模型的反思和代码更新驱动的数据高效、非基于梯度的学习机制。

这一点之所以至关重要,是因为它标志着AI从一个被动接受训练和优化的“对象”,转变为一个能够主动进行自我迭代和完善的“主体”。更深层的意义在于,这种模式开启了**复利式增长(compounding improvements)**的可能性:AI在改进自身编码能力后,能利用这种更强的能力在下一轮迭代中做出更高效的改进。它不仅仅是在学习解决问题,更是在学习如何“更好地学习”,这是一种根本性的范式转变。

效果惊人,在复杂软件工程任务上实现巨大飞跃

自改进听起来很酷,但它真的有效吗?论文用极具冲击力的数据给出了肯定的答案。在一个名为SWE-Bench Verified的权威测试的随机子集上(这是一个用于衡量AI处理真实世界软件工程问题能力的基准),SICA的性能从最初的17%飙升到了53%。

这意味着,通过15轮的自我迭代,这个AI系统解决复杂编程问题的能力提升至原来的三倍以上,实现了超过200%的惊人增长。

更值得注意的是,SICA的进化目标并非单一的性能指标。它的迭代是由一个综合了性能、成本和时间的“效用函数”来引导的。这意味着系统在提升解决问题能力的同时,还在积极地让自己变得更“经济实惠”——用更少的时间和计算资源完成任务。

这一点的重要性在于,它无可辩驳地证明了自改进方法不仅仅是一个理论上的概念。它能够在实际、复杂且充满挑战的编码任务中,带来可量化的、巨大的性能收益,这为AI在软件工程领域的应用打开了全新的想象空间。

进化之路——AI为自己“发明”并迭代新工具

SICA的性能提升并非通过调整神经网络的权重参数,而是通过一种更接近人类工程师的方式:编辑代码库、创造新工具来解决具体问题。它的进化之路清晰地展现了一个迭代和演进的过程,而非一次性的灵感爆发。

例如,在它的自我改进过程中,工具的演化路径清晰可见:

- “智能编辑器 (Smart Editor)”的诞生与演进:起初,AI用低效的“完整覆盖”方式编辑文件。它很快意识到瓶颈,为自己发明了“智能编辑器”,能根据编辑任务的特性选择最优策略。随后,它又为这个编辑器增加了基于diff的智能编辑策略,并不断优化,最终实现了更高效、更低成本的代码修改。

- 从理解到导航的工具链:为了在大型代码库中快速定位信息,SICA创造了**“代码上下文摘要器 (Code Context Summarizer)”,帮助自己更快地理解项目结构。紧接着,为了实现更精确的代码导航,它又集成了基于抽象语法树(AST)的“AST符号定位器”**,使其能像现代IDE一样准确找到符号定义。

这个发现的意义非凡。它表明AI不仅能执行任务,更能创造性地改进执行任务的方式。它展现了高级的问题解决能力——识别瓶颈,并自主设计、实现并迭代解决方案,这正是优秀人类开发者的核心特质。

出人意料的“滑铁卢”——在纯粹推理任务上效果不佳

就在我们惊叹于SICA在编码任务上的卓越表现时,论文揭示了一个反直觉的发现:在纯粹的推理任务上(如AIME数学竞赛和GPQA高难度问答),SICA的自改进框架几乎没有带来任何性能提升。

研究人员对此的解释是,对于那些本身推理能力已经极强的基础模型(如论文中使用的o3-mini),SICA添加的这套复杂的“脚手架”系统(如任务分解、调用子代理等)可能反而会“打断其固有的推理思路”,导致性能不升反降。

这一点的重要性在于,它深刻揭示了AI智能体设计中一个根本性的张力:外部“脚手架”(scaffolding)与模型内在“认知”(cognition)之间的冲突。它提醒我们,AI能力的提升并非简单地将强大的基础模型与复杂的外部框架进行叠加。对于高度依赖连贯思维链的纯粹推理任务,外部的僵硬流程可能会成为一种干扰而非辅助。如何设计能够增强而非打断模型内在能力的智能体框架,是未来AI发展必须面对的核心挑战。

AI也需要“监工”——确保自主运行不“跑偏”

让一个强大的AI长时间自主运行,如何确保它不陷入死循环、不偏离最初的目标?SICA系统给出了一个非常务实的答案:为它配备一个“异步监察者 (asynchronous overseer)”。

这个“监察者”本身也是一个大语言模型,它在后台独立运行,像一个真正的项目监工一样,定期检查主智能体的工作状态。它会判断主智能体是否存在陷入循环、偏离任务或其他病态行为。一旦发现问题,“监察者”可以进行干预,例如向主智能体发送一条提醒信息,或者在极端情况下,直接强制取消其当前的执行。

这个发现的重要性在于,它将AI安全性和稳定性提升到了系统设计的核心层面。在构建日益强大的自主AI系统时,设计这样的“安全网”或“熔断机制”是确保AI能够可靠、安全地长时间自主工作的关键一步,也是通往更高级别AI自治的必经之路。

当AI开始自我编程,未来将走向何方?

SICA的出现,清晰地表明AI正从一个被动的、需要人类精心雕琢的工具,演变为一个能够主动、自主进行迭代和改进的实体。然而,它的成功与失败共同勾勒出了一幅更为复杂和有趣的图景:我们目前见证的,是一种专注于优化自身工具和流程的“外骨骼式”进化,而非核心内在推理能力的跃升。

这种强大的自我改造能力,既是其在软件工程任务上取得惊人成就(发现二和三)的原因,也解释了为何需要一个“监工”(发现五)来约束其行为,防止其强大的执行力“跑偏”。同时,这也揭示了其在纯粹认知任务上的局限性(发现四)。

这迫使我们思考一个更深层次的问题:当AI的进化主要体现在优化自身工具与流程,而非核心推理时,我们该如何引导这种“外骨骼式”的智能演化,并确保其强大的自我改造能力始终与我们的目标对齐?